基于 SparkCore 的天气监测器(含代码)

9

9

拍明

拍明

原标题:基于 SparkCore 的天气监测器(含代码)

一、系统概述

基于SparkCore的天气监测器主要包括数据采集、数据预处理、数据存储、数据分析和数据可视化等模块。数据采集模块负责从各种天气传感器中收集数据,数据预处理模块则对采集到的数据进行清洗和格式化,以便后续分析。数据存储模块将数据保存在可靠的存储介质中,如Hadoop分布式文件系统(HDFS)或数据库。数据分析模块利用SparkCore的强大计算能力对存储的数据进行深入分析,提取有价值的信息。最后,数据可视化模块将分析结果以图表、图像等形式直观地展示出来。

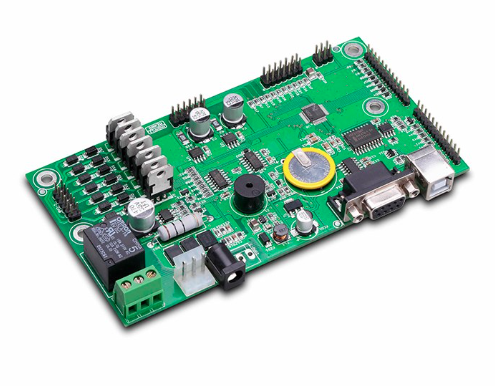

二、主控芯片型号及其作用

在设计基于SparkCore的天气监测器时,主控芯片的选择至关重要。主控芯片负责协调整个系统的运行,包括数据处理、存储和通信等功能。以下是一些可能的主控芯片型号及其在设计中的作用:

SparkCore(基于Arduino平台)

型号:SparkCore(或兼容的Arduino板,如Arduino Uno、Arduino Mega等)

作用:作为系统的控制核心,SparkCore负责接收来自传感器的数据,通过串口通信等方式将数据发送到Spark集群进行处理。它还负责接收来自Spark集群的分析结果,并通过各种接口(如LCD显示屏、LED指示灯等)将结果显示给用户。

ARM Cortex-M系列

型号:如STM32F4系列、NXP i.MX系列等

作用:ARM Cortex-M系列芯片具有高性能、低功耗的特点,非常适合用于天气监测器中作为数据处理和控制的核心。它们可以处理来自多个传感器的数据,执行复杂的算法,并将处理后的数据发送到Spark集群进行进一步分析。

RISC-V系列

型号:如SiFive Freedom系列、RISC-V Development Board等

作用:RISC-V系列芯片是一种开源的指令集架构,具有高度的灵活性和可扩展性。在天气监测器中,RISC-V芯片可以作为数据处理和控制的核心,通过定制化的指令集和硬件加速功能,提高数据处理效率和降低功耗。

ESP32系列

型号:如ESP32-WROOM-32、ESP32-S系列等

作用:ESP32系列芯片集成了Wi-Fi和蓝牙功能,非常适合用于需要无线通信的天气监测器中。它们可以轻松地连接到互联网,将数据传输到远程的Spark集群进行处理和分析。同时,ESP32还具有强大的数据处理能力,可以执行一些基本的算法和数据处理任务。

三、代码示例

以下是一个基于SparkCore的天气监测器的部分代码示例,包括数据采集、数据预处理和数据分析等模块的代码。请注意,这只是一个简化的示例,实际的系统可能需要更复杂的代码和更多的模块。

1. 数据采集模块

数据采集模块使用Python语言编写,通过模拟传感器接口来收集数据。以下是一个简单的数据采集代码示例:

import time import random

# 模拟传感器接口 def read_sensor_data(): temperature = random.uniform(20.0, 30.0) # 随机生成温度数据 humidity = random.uniform(50.0, 80.0) # 随机生成湿度数据 pressure = random.uniform(1000.0, 1020.0) # 随机生成气压数据 return {"temperature": temperature, "humidity": humidity, "pressure": pressure}

# 采集数据并打印 while True: data = read_sensor_data() print(f"Temperature: {data['temperature']}°C, Humidity: {data['humidity']}%, Pressure: {data['pressure']}hPa") time.sleep(5) # 每5秒采集一次数据

2. 数据预处理模块

数据预处理模块使用Pandas库对数据进行清洗和格式化。以下是一个简单的数据预处理代码示例:

import pandas as pd

# 假设这是从传感器采集到的原始数据 raw_data = [ {"timestamp": "2023-10-01T00:00:00", "temperature": 25.1, "humidity": 60.2, "pressure": 1010.5}, {"timestamp": "2023-10-01T00:05:00", "temperature": 25.3, "humidity": 60.5, "pressure": 1010.8}, # ... 更多数据 ]

# 将原始数据转换为DataFrame df = pd.DataFrame(raw_data)

# 将时间戳转换为datetime类型 df['timestamp'] = pd.to_datetime(df['timestamp'])

# 设置时间戳为索引 df.set_index('timestamp', inplace=True)

# 打印预处理后的数据 print(df.head())

3. 数据分析模块

数据分析模块使用Spark Core进行大规模数据处理和分析。以下是一个简单的数据分析代码示例,使用Scala语言编写:

import org.apache.spark.sql.SparkSession

object WeatherAnalysis { def main(args: Array[String]): Unit = { // 创建SparkSession val spark = SparkSession.builder() .appName("WeatherAnalysis") .getOrCreate()

// 读取预处理后的数据(假设已经保存到HDFS或数据库中) val df = spark.read.format("csv").option("header", "true").load("hdfs:///path/to/preprocessed_data.csv")

// 分析每个月的平均气温 val monthlyAvgTemp = df.groupBy(df.col("timestamp").cast("date").cast("string").substr(0, 7)) // 提取年月 .agg(avg("temperature").as("avg_temperature"))

// 打印分析结果 monthlyAvgTemp.show()

// 停止SparkSession spark.stop() } }

请注意,上述代码示例中的文件路径和数据格式可能需要根据实际情况进行调整。此外,实际的系统还需要考虑数据的实时性、数据的存储和传输方式、系统的稳定性和可靠性等问题。

四、总结

基于SparkCore的天气监测器是一个复杂的系统,需要综合考虑数据采集、数据预处理、数据存储、数据分析和数据可视化等多个模块。在选择主控芯片时,需要根据系统的具体需求和性能要求来选择合适的芯片型号。通过合理的代码设计和优化,可以实现高效、准确和可靠的天气监测功能。

责任编辑:David

【免责声明】

1、本文内容、数据、图表等来源于网络引用或其他公开资料,版权归属原作者、原发表出处。若版权所有方对本文的引用持有异议,请联系拍明芯城(marketing@iczoom.com),本方将及时处理。

2、本文的引用仅供读者交流学习使用,不涉及商业目的。

3、本文内容仅代表作者观点,拍明芯城不对内容的准确性、可靠性或完整性提供明示或暗示的保证。读者阅读本文后做出的决定或行为,是基于自主意愿和独立判断做出的,请读者明确相关结果。

4、如需转载本方拥有版权的文章,请联系拍明芯城(marketing@iczoom.com)注明“转载原因”。未经允许私自转载拍明芯城将保留追究其法律责任的权利。

拍明芯城拥有对此声明的最终解释权。

产品分类

产品分类

2012- 2022 拍明芯城ICZOOM.com 版权所有 客服热线:400-693-8369 (9:00-18:00)

2012- 2022 拍明芯城ICZOOM.com 版权所有 客服热线:400-693-8369 (9:00-18:00)