为转型变压器网络做好准备

8

8

莎莉·沃德-福克斯顿

莎莉·沃德-福克斯顿

原标题:为转型变压器网络做好准备

为了转型变压器网络并做好相关准备,以下是一些关键步骤和考虑因素:

理解现有网络:

首先,需要对当前的变压器网络有深入的了解,包括其结构、功能、运行状态和存在的问题等[1]。

了解网络中的瓶颈和潜在风险,以便在转型过程中进行针对性的优化和升级。

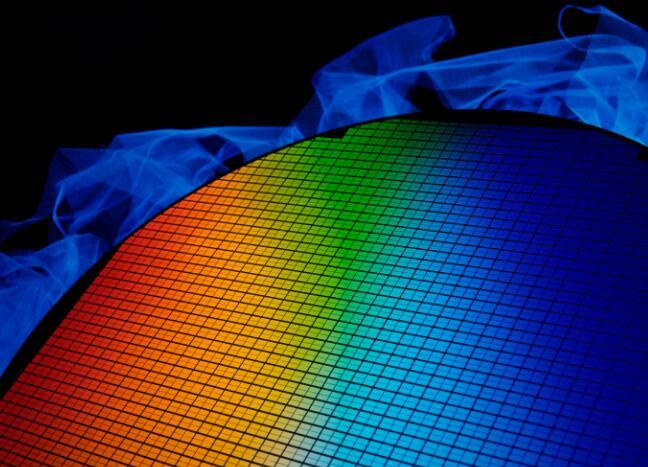

技术评估与选择:

评估现有技术与新技术之间的差距,以及新技术对变压器网络转型的潜在影响[1]。

考虑到5G网络变压器的特点,如更高的频率、更小的尺寸、更低的功耗、更高的可靠性等,这些特点都有助于提升变压器网络的性能[3]。

根据实际需求选择合适的技术方案,确保技术可行性和经济效益。

制定转型计划:

制定详细的转型计划,包括时间表、预算、人员配置等[5]。

明确转型的目标和预期效果,确保计划与实际需求相符。

考虑到可能出现的风险和挑战,制定应对措施和应急预案。

培训与人员准备:

对相关人员进行培训,使其掌握新技术和操作方法[5]。

组建专业的技术团队,负责转型过程中的技术支持和问题解决。

设备采购与升级:

根据转型计划,采购所需的设备和材料,确保设备质量和性能符合要求[1]。

对现有设备进行升级或替换,以适应新技术和新的网络环境。

测试与验证:

在转型完成后,进行充分的测试和验证,确保新网络的稳定性和可靠性[1]。

发现问题及时修复和优化,确保网络性能达到预期目标。

维护与优化:

建立完善的维护体系,定期对网络进行巡检和保养[1]。

收集和分析运行数据,对网络性能进行持续优化和改进。

合规与监管:

确保转型过程符合相关法律法规和行业标准[5]。

遵循监管要求,确保变压器网络的安全、稳定和可靠运行。

合作伙伴与生态系统:

与合作伙伴建立紧密的合作关系,共同推动变压器网络的转型和升级[5]。

构建完善的生态系统,促进新技术和应用的推广和应用。

请注意,以上步骤和考虑因素仅作为一般参考,具体转型方案需根据实际情况进行调整和优化。同时,在转型过程中需保持谨慎和灵活,随时应对可能出现的风险和挑战。

责任编辑:David

【免责声明】

1、本文内容、数据、图表等来源于网络引用或其他公开资料,版权归属原作者、原发表出处。若版权所有方对本文的引用持有异议,请联系拍明芯城(marketing@iczoom.com),本方将及时处理。

2、本文的引用仅供读者交流学习使用,不涉及商业目的。

3、本文内容仅代表作者观点,拍明芯城不对内容的准确性、可靠性或完整性提供明示或暗示的保证。读者阅读本文后做出的决定或行为,是基于自主意愿和独立判断做出的,请读者明确相关结果。

4、如需转载本方拥有版权的文章,请联系拍明芯城(marketing@iczoom.com)注明“转载原因”。未经允许私自转载拍明芯城将保留追究其法律责任的权利。

拍明芯城拥有对此声明的最终解释权。

产品分类

产品分类

2012- 2022 拍明芯城ICZOOM.com 版权所有 客服热线:400-693-8369 (9:00-18:00)

2012- 2022 拍明芯城ICZOOM.com 版权所有 客服热线:400-693-8369 (9:00-18:00)