NVIDIA:DPU将成为驱动数据中心网络运作的引擎

17

17

拍明

拍明

原标题:NVIDIA:DPU将成为驱动数据中心网络运作的引擎

NVIDIA的DPU(数据处理单元)在数据中心领域正逐步成为驱动网络运作的关键引擎。以下是对这一观点的详细解析:

一、DPU的定义与重要性

DPU是一种专门设计用于处理数据中心内数据移动和处理的芯片,是继CPU(中央处理器)和GPU(图形处理器)之后的“第三颗主力芯片”。DPU的主要作用是卸载原本运行在CPU、GPU中的通用数据处理任务,如网络、存储、安全等,从而释放CPU、GPU的算力,使它们能够更专注于核心的计算任务。

二、DPU的技术特点与优势

高效卸载与加速:DPU能够高效卸载并加速数据中心内的网络和存储任务,同时提供安全和管理等基础功能。这种卸载和加速机制使得数据中心能够处理更多的并发请求,提高整体运行效率。

虚拟化与安全:DPU支持硬件级别的虚拟化,可以在不牺牲裸机性能的情况下提供虚拟化和高级安全功能。这种特性使得数据中心能够更好地支持云原生应用和多租户环境。

可编程性与灵活性:DPU具备通用层级化可编程性,可以根据不同的应用场景进行灵活配置和优化。这种灵活性使得DPU能够适应不同规模和复杂度的数据中心需求。

三、NVIDIA DPU的发展与应用

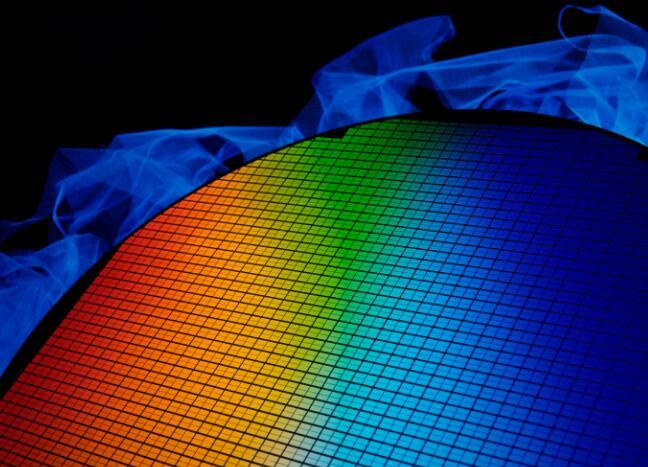

NVIDIA在DPU领域处于领先地位,其BlueField系列DPU已经得到了广泛的应用和认可。以下是NVIDIA DPU的几个重要发展节点:

BlueField-2的发布:NVIDIA在前几年发布了首代DPU BlueField-2,该芯片在数据中心领域取得了显著成效,为后续的DPU产品奠定了基础。

CPU+GPU+DPU战略的提出:NVIDIA在GTC大会上宣布了其芯片战略正式升级为CPU+GPU+DPU,这标志着NVIDIA对DPU市场的重视和投入。

新一代DPU的研发:NVIDIA正在积极研发新一代DPU产品,如BlueField-3和BlueField-4。这些新产品将具备更高的网络速度和更强的计算能力,以满足数据中心日益增长的需求。

四、DPU在数据中心网络运作中的作用

加速网络处理:DPU能够加速网络数据的处理和转发,提高网络带宽利用率和吞吐量。这使得数据中心能够更快地响应外部请求,提升用户体验。

优化存储性能:DPU通过卸载存储任务并加速存储访问,可以提高数据中心的存储性能。这有助于降低存储延迟和成本,提升数据中心的运营效率。

增强安全性:DPU内置的安全功能可以保护数据中心免受网络攻击和数据泄露等威胁。这有助于提升数据中心的安全性和可靠性。

综上所述,NVIDIA的DPU正在逐步成为驱动数据中心网络运作的引擎。通过卸载和加速数据中心内的通用数据处理任务,DPU为CPU和GPU释放了更多的算力资源,使得数据中心能够更高效地运行各种应用和服务。随着技术的不断进步和应用场景的不断拓展,DPU在数据中心领域的作用将会越来越重要。

责任编辑:

【免责声明】

1、本文内容、数据、图表等来源于网络引用或其他公开资料,版权归属原作者、原发表出处。若版权所有方对本文的引用持有异议,请联系拍明芯城(marketing@iczoom.com),本方将及时处理。

2、本文的引用仅供读者交流学习使用,不涉及商业目的。

3、本文内容仅代表作者观点,拍明芯城不对内容的准确性、可靠性或完整性提供明示或暗示的保证。读者阅读本文后做出的决定或行为,是基于自主意愿和独立判断做出的,请读者明确相关结果。

4、如需转载本方拥有版权的文章,请联系拍明芯城(marketing@iczoom.com)注明“转载原因”。未经允许私自转载拍明芯城将保留追究其法律责任的权利。

拍明芯城拥有对此声明的最终解释权。

产品分类

产品分类

2012- 2022 拍明芯城ICZOOM.com 版权所有 客服热线:400-693-8369 (9:00-18:00)

2012- 2022 拍明芯城ICZOOM.com 版权所有 客服热线:400-693-8369 (9:00-18:00)