给内存加上AI?三星是这样做的

17

17

拍明

拍明

原标题:给内存加上AI?三星是这样做的

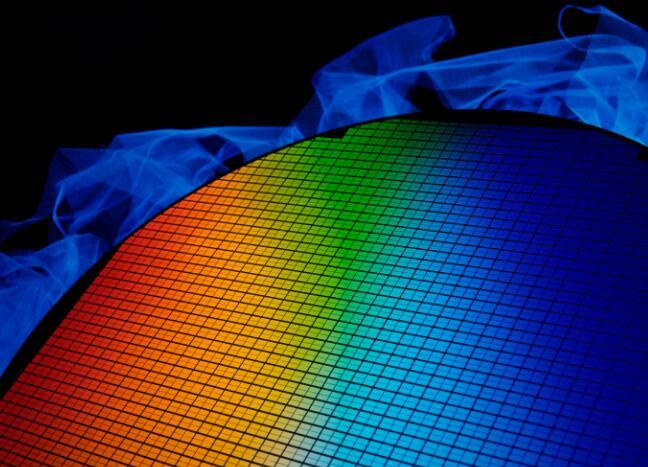

三星在将AI技术融入内存方面取得了显著进展,主要通过内存内处理(PIM)技术实现。以下是三星在这一领域的具体做法和成果:

一、技术背景与意义

随着人工智能(AI)算法和应用程序的快速发展,数据处理需求急剧增长。传统的内存解决方案在容量、带宽和能效方面已难以满足AI应用的需求。因此,三星等厂商开始探索将AI处理能力直接集成到内存中的方法,以减少数据移动带来的延迟和能耗,提高整体性能。

二、具体做法

HBM-PIM技术

三星首次成功将基于PIM的高带宽存储器(HBM-PIM)整合到商用化加速器系统中。HBM-PIM通过在高带宽内存(HBM)中集成内存内处理(PIM)功能,实现了AI处理能力的直接集成。

三星推出的首个HBM-PIM产品(Aquabolt-XL)将AI处理能力整合到三星HBM2 Aquabolt中,显著增强了超级计算机和AI应用的高速数据处理能力。

HBM-PIM在赛灵思(Xilinx)Virtex Ultrascale+(Alveo)AI加速器中进行了测试,结果显示其系统性能提升了近2.5倍,能耗降低了超过60%。

DRAM模组与移动内存

三星不仅将PIM技术应用于HBM,还将其应用范围扩大至DRAM模组和移动内存。例如,三星的加速DIMM(AXDIMM)能在DRAM模块内进行“处理”,减少CPU和DRAM之间的大量数据交换,提升AI加速器系统的能源效率。

AXDIMM模块能保留传统DIMM的外形尺寸,因此可以在不修改系统的情况下直接替换。目前,AXDIMM正在客户的服务器上进行测试,能够在基于AI的推荐应用中提供大约2倍的性能,并使整个系统的能耗减少40%。

LPDDR5-PIM移动存储器

三星还开发了LPDDR5-PIM移动存储器,该存储器可在不连接数据中心的情况下提供独立的AI功能。模拟测试表明,LPDDR5-PIM在用于语音识别、翻译和聊天机器人等应用时,性能可提升1倍以上,同时能耗减少60%以上。

三、未来展望

三星计划通过与其他行业领导者合作,在2022年上半年实现PIM平台标准化,从而扩展AI内存产品组合。此外,三星还将继续努力培养一个高度健全的PIM生态系统,以确保整个内存市场的广泛适用性。

随着技术的不断发展,三星的PIM技术有望在未来进一步提升AI应用的性能和能效,推动AI技术的普及和应用。同时,这也将促进整个半导体行业的创新和发展。

责任编辑:David

【免责声明】

1、本文内容、数据、图表等来源于网络引用或其他公开资料,版权归属原作者、原发表出处。若版权所有方对本文的引用持有异议,请联系拍明芯城(marketing@iczoom.com),本方将及时处理。

2、本文的引用仅供读者交流学习使用,不涉及商业目的。

3、本文内容仅代表作者观点,拍明芯城不对内容的准确性、可靠性或完整性提供明示或暗示的保证。读者阅读本文后做出的决定或行为,是基于自主意愿和独立判断做出的,请读者明确相关结果。

4、如需转载本方拥有版权的文章,请联系拍明芯城(marketing@iczoom.com)注明“转载原因”。未经允许私自转载拍明芯城将保留追究其法律责任的权利。

拍明芯城拥有对此声明的最终解释权。

产品分类

产品分类

2012- 2022 拍明芯城ICZOOM.com 版权所有 客服热线:400-693-8369 (9:00-18:00)

2012- 2022 拍明芯城ICZOOM.com 版权所有 客服热线:400-693-8369 (9:00-18:00)