什么是显卡芯片,显卡芯片的基础知识?

1

1

拍明芯城

拍明芯城

显卡芯片是现代计算机系统中至关重要的组成部分,它负责处理和生成计算机屏幕上显示的所有图像数据。从简单的文字显示到复杂的三维渲染,显卡芯片都在幕后默默工作,为用户提供流畅、逼真的视觉体验。随着计算机技术的发展,显卡芯片的性能和复杂性也在不断提升,如今已成为衡量一台计算机图形处理能力的核心指标。

一、 显卡芯片的定义与核心作用

显卡芯片,全称图形处理器(Graphics Processing Unit,GPU),是一种专门用于处理计算机图形输出的微处理器。与中央处理器(CPU)不同,GPU在设计上更侧重于并行计算能力,能够同时处理大量的图形数据,这使得它在执行图形渲染任务时效率远高于CPU。显卡芯片是显卡(Graphics Card)的核心组件,通常以集成电路的形式封装在显卡PCB板上,或者直接集成在CPU内部(称为集成显卡)。

显卡芯片的核心作用主要体现在以下几个方面:

图像渲染与显示: 这是显卡芯片最基本也是最重要的功能。它接收来自CPU的图形指令,将其转化为像素信息,并通过数模转换器(DAC)或直接数字输出(如HDMI、DisplayPort)将图像信号发送给显示器,最终呈现在用户眼前。无论是桌面环境、网页浏览、视频播放还是游戏,所有视觉内容的生成都离不开显卡芯片的参与。

三维图形加速: 现代计算机图形应用,特别是游戏和专业设计软件,大量使用三维图形。显卡芯片通过硬件加速,能够高效地完成三维模型的顶点处理、光栅化、纹理映射、着色等复杂运算,极大地提升了三维图像的生成速度和质量,使得实时三维渲染成为可能。

通用计算(GPGPU): 随着显卡芯片并行计算能力的不断增强,其应用范围也从传统的图形处理扩展到通用计算领域。通过CUDA、OpenCL等编程接口,开发者可以利用GPU强大的并行处理能力来加速科学计算、数据分析、人工智能(深度学习)、密码学、金融建模等非图形密集型任务,极大地缩短了计算时间。这种趋势使得GPU不仅仅是图形处理器,更成为了高性能计算的重要引擎。

视频编解码: 许多现代显卡芯片内置了专门的视频编解码器,可以硬件加速视频的编码和解码过程。这不仅能减轻CPU的负担,还能在保证视频质量的前提下,实现更流畅的视频播放和更快速的视频编辑、转码,对于高清视频和流媒体应用尤为重要。

多显示器支持: 显卡芯片通常提供多个显示输出接口,可以同时连接多个显示器,实现多屏显示。这对于专业用户(如设计师、交易员)和游戏玩家来说非常有用,可以扩展工作空间或提供更沉浸式的游戏体验。

二、 显卡芯片的发展历程

显卡芯片的发展历程是一部技术不断迭代、性能不断飞跃的历史,大致可以分为以下几个阶段:

早期字符/简单图形显示(1970s-1980s): 早期计算机的显示功能非常有限,主要以字符显示为主。显卡芯片的功能仅限于将字符编码转换为点阵图案,并将其显示在屏幕上。例如,IBM PC XT时代的MDA(单色显示适配器)和CGA(彩色图形适配器)是这一时期的代表。它们的图形处理能力非常弱,基本上没有硬件加速功能。

2D图形加速时代(1990s): 随着Windows操作系统的普及,图形用户界面(GUI)成为主流,2D图形加速变得越来越重要。显卡芯片开始集成专门的2D加速器,能够硬件加速位图操作、线条绘制、填充等任务,显著提升了Windows界面的流畅度和响应速度。这一时期涌现出S3 Graphics、ATI(后被AMD收购)、Matrox等知名显卡芯片制造商。

3D图形加速的萌芽与发展(1990s末期-2000s初期): 随着游戏产业的兴起,对实时三维图形的需求日益增长。1990年代中期,3Dfx Interactive推出了Voodoo系列显卡,首次将可编程流水线引入消费级显卡,实现了硬件加速的三维渲染,极大地改变了PC游戏的体验。此后,NVIDIA(英伟达)和ATI成为3D图形加速领域的两大巨头,它们不断推出性能更强的GPU,支持更复杂的3D特效,并推动了DirectX和OpenGL等API的发展。这一时期,显卡芯片开始引入顶点着色器和像素着色器等可编程单元。

统一渲染架构与通用计算兴起(2000s中期-2010s初期): 到了2000年代中期,NVIDIA率先推出了统一渲染架构,将顶点着色器和像素着色器统一为流处理器,提高了GPU资源的利用率和编程灵活性。同时,CUDA和OpenCL等通用计算框架的出现,使得GPU的并行计算能力可以被非图形应用所利用,开启了GPGPU时代。GPU的应用范围从游戏扩展到科学计算、数据分析等领域。

人工智能与光线追踪时代(2010s中期至今): 近年来,人工智能(AI)的飞速发展为GPU带来了新的机遇。深度学习训练需要 massive 并行计算能力,GPU的架构恰好能够满足这一需求。NVIDIA的Tensor Cores等专用AI加速单元的引入,使得GPU在AI计算方面表现出惊人的效率。同时,实时光线追踪技术的兴起,为游戏和电影渲染带来了前所未有的真实感,虽然对GPU性能提出了极高的要求,但各大厂商都在积极研发和推广支持光线追踪的GPU。

三、 显卡芯片的组成部分

现代显卡芯片是一个高度复杂的集成电路,内部集成了数以亿计甚至上百亿的晶体管。其核心组成部分包括:

流处理器(Streaming Processors/CUDA Cores/Shader Cores): 这是GPU的核心计算单元,负责执行各种图形和通用计算任务。一个现代GPU通常包含数千个甚至上万个流处理器,它们以高度并行的方式协同工作,处理大量的顶点、像素、几何和通用计算数据。NVIDIA称之为CUDA核心,AMD则称之为流处理器。

纹理单元(Texture Mapping Units,TMUs): 纹理是图像表面细节的表现,纹理单元负责处理纹理的采样、过滤和贴图,将二维纹理图像映射到三维模型的表面上,使得物体看起来更加真实。

光栅化单元(Raster Operators,ROPs): 光栅化是三维渲染管线中的关键步骤,它将三维几何数据转换为可在屏幕上显示的像素。ROPs负责处理像素的最终输出,包括混合(blending)、抗锯齿(anti-aliasing)、深度测试(depth testing)、模板测试(stencil testing)等操作,确保像素正确地显示。

几何单元/几何着色器(Geometry Units/Geometry Shaders): 几何单元负责处理三维模型的几何信息,例如顶点坐标、法线向量等。几何着色器能够动态地生成或删除几何图元(如点、线、三角形),实现复杂的几何变换和细节生成。

内存控制器(Memory Controller): 显卡芯片需要高速访问显存来存储图像数据、纹理、帧缓冲等。内存控制器负责管理GPU与显存之间的数据传输,确保数据能够高效、稳定地流动。现代GPU通常使用GDDR系列显存(如GDDR6、GDDR6X),提供极高的带宽。

显存(Video Memory/VRAM): 虽然显存是独立于GPU的存储芯片,但它是显卡芯片高效运行不可或缺的一部分。显存用于临时存储所有与图形渲染相关的数据,例如帧缓冲(frame buffer,存储最终要显示的图像)、Z-缓冲(Z-buffer,存储深度信息)、纹理数据、顶点数据、着色器程序等。显存的容量和带宽对显卡的性能有显著影响。

显示控制器(Display Controller): 显示控制器负责将处理完成的图像数据转换为显示器可以识别的信号,并通过各种显示接口(如HDMI、DisplayPort、DVI、VGA)输出给显示器。它也可能包含一些附加功能,如多显示器管理和色彩空间转换。

视频编解码单元(Video Engine/Codec): 许多现代GPU包含专用的硬件编解码器,如NVIDIA的NVENC/NVDEC和AMD的VCE/UVD,用于加速视频的编码和解码,支持H.264、H.265(HEVC)、VP9、AV1等多种视频格式。

PCI Express接口: 这是显卡与主板之间的数据传输接口。PCI Express(PCIe)提供高带宽的数据通道,使得CPU和GPU之间能够快速交换数据和指令。

四、 显卡芯片的核心技术与架构

显卡芯片的性能和功能由其内部的核心技术和架构决定。以下是一些关键概念:

并行计算与SM/CU: GPU的强大之处在于其大规模并行计算能力。它由大量的计算单元组成,NVIDIA称之为“流式多处理器”(Streaming Multiprocessor,SM),AMD则称之为“计算单元”(Compute Unit,CU)。每个SM/CU内部包含多个流处理器、纹理单元、缓存等,它们能够同时执行数千个线程,从而高效处理并行任务。这种“大数据并行”的架构是GPU与CPU最本质的区别。

渲染管线(Rendering Pipeline): 渲染管线是GPU从三维模型数据到最终屏幕像素的完整处理流程。它通常包括以下阶段:

顶点处理(Vertex Processing): 对三维模型的每个顶点进行坐标变换、光照计算等。

图元装配(Primitive Assembly): 将处理后的顶点组合成基本图元(如点、线、三角形)。

几何处理(Geometry Processing): 可选阶段,可对图元进行额外处理,如生成更多几何细节。

光栅化(Rasterization): 将三维图元投影到二维屏幕空间,并确定每个像素是否被覆盖。

片段着色/像素着色(Fragment/Pixel Shading): 对每个通过光栅化生成的像素进行颜色计算、纹理采样、光照计算等,确定其最终颜色。

光栅操作/混合(Raster Operations/Blending): 对最终像素进行深度测试、模板测试、颜色混合等,确定最终输出到帧缓冲的颜色。

可编程着色器(Programmable Shaders): 现代GPU的核心是可编程着色器。顶点着色器、几何着色器和像素着色器允许开发者编写程序来控制渲染管线中的特定阶段,从而实现各种复杂的图形特效,如动态光照、高级材质、后处理效果等。这使得图形渲染变得更加灵活和富有表现力。

统一着色器架构(Unified Shader Architecture): 早期的GPU有独立的顶点着色器和像素着色器。统一着色器架构将这两者统一起来,形成一组通用的流处理器,可以根据需要动态地分配给顶点处理或像素处理任务。这提高了GPU资源的利用率和调度灵活性。

显存技术(VRAM Technologies): 显存的性能对显卡至关重要。

DDR/GDDR系列: 早期显卡使用DDR SDRAM,后来演变为专为图形处理优化的GDDR系列(Graphics Double Data Rate SDRAM),如GDDR5、GDDR6、GDDR6X。GDDR显存具有高带宽、高频率的特点。

HBM(High Bandwidth Memory): HBM是一种创新的3D堆叠封装技术,将DRAM芯片垂直堆叠并直接集成在GPU旁边,通过短而宽的总线连接,提供比传统GDDR显存高得多的带宽和更低的功耗。HBM主要用于高端专业显卡和数据中心GPU。

缓存(Cache): 显卡芯片内部也包含多级缓存,用于存储常用的数据和指令,以减少对显存的访问延迟,提高数据处理效率。

光线追踪(Ray Tracing): 光线追踪是一种先进的渲染技术,通过模拟光线从光源发出、反射、折射并最终进入眼睛的过程来生成图像。它能产生极其真实的光影、反射和折射效果,但计算量巨大。现代GPU通过专门的硬件加速单元(如NVIDIA的RT Cores)来加速光线追踪计算,使得实时光线追踪成为可能。

人工智能/机器学习加速(AI/ML Acceleration): 随着AI技术的发展,GPU在深度学习训练和推理中扮演着越来越重要的角色。部分GPU集成了专门的AI加速单元(如NVIDIA的Tensor Cores),能够高效执行矩阵乘法和累加等深度学习核心运算,极大地提升了AI任务的处理速度。

五、 显卡芯片的制造工艺

显卡芯片的制造是一个极其复杂和精密的工程,涉及到纳米级别的技术。

晶体管与摩尔定律: 显卡芯片由数十亿甚至上百亿个晶体管组成。晶体管是构成集成电路的基本开关单元。随着制造工艺的进步,单个晶体管的尺寸不断缩小,使得在相同面积的芯片上可以集成更多的晶体管,从而提升性能和集成度。这就是著名的摩尔定律(Moore's Law)的体现。

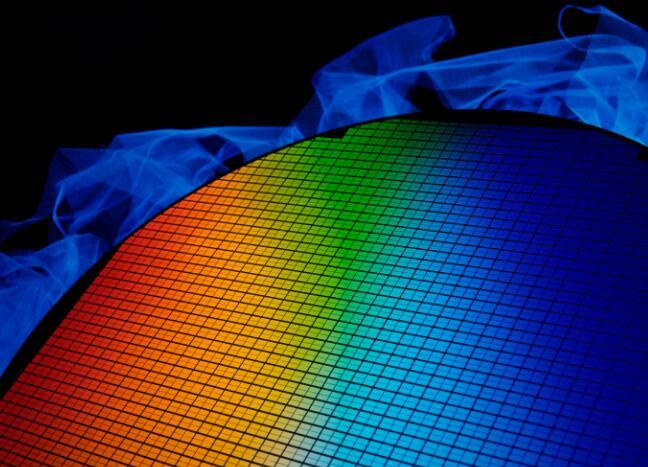

半导体材料: 显卡芯片主要由硅晶圆制造。硅是一种半导体材料,其导电性介于导体和绝缘体之间,可以通过掺杂和控制其物理结构来实现晶体管的功能。

光刻(Photolithography): 这是芯片制造中最核心的工艺之一。光刻技术利用紫外线或极紫外线(EUV)将电路图案“曝光”到涂有光敏材料的硅晶圆上,然后通过化学蚀刻去除不需要的部分,形成电路结构。随着晶体管尺寸的缩小,光刻技术的精度要求也越来越高。

制程节点(Process Node): 制程节点(如7nm、5nm、3nm)通常指的是晶体管的最小特征尺寸,但现在更多地作为衡量半导体制造技术先进程度的营销术语。更小的制程节点意味着晶体管密度更高、性能更强、功耗更低。目前,台积电(TSMC)和三星(Samsung)是全球领先的显卡芯片代工厂商。

封装(Packaging): 制造完成的芯片晶圆需要经过切割、测试和封装。封装是将裸芯片固定在基板上,并引出管脚,以便连接到电路板上。封装技术也在不断发展,例如倒装芯片(Flip-Chip)技术和2.5D/3D堆叠封装(如HBM),旨在提供更好的散热和更短的信号路径。

六、 显卡芯片的品牌与市场格局

在全球显卡芯片市场,主要的参与者有:

NVIDIA(英伟达): 毫无疑问,NVIDIA是全球最大的独立显卡芯片供应商。其GeForce系列GPU在游戏市场占据主导地位,而Quadro系列则面向专业工作站。近年来,NVIDIA在数据中心、人工智能、自动驾驶等领域也取得了巨大成功,其CUDA平台成为GPGPU计算的事实标准。NVIDIA以其强大的研发实力和生态系统建设,始终引领着GPU技术的发展方向。

AMD(超微): AMD是NVIDIA的主要竞争对手。其Radeon系列GPU在游戏市场与NVIDIA展开激烈竞争,并在性价比方面具有一定优势。AMD也提供面向专业领域的Radeon Pro系列GPU。除了独立显卡芯片,AMD还是CPU和集成显卡(APU)领域的领导者,其APU产品在主流笔记本和入门级台式机市场占据重要份额。AMD的Adrenalin驱动和FreeSync技术在游戏社区也备受好评。

Intel(英特尔): 长期以来,Intel在独立显卡芯片市场几乎缺席,主要通过其集成在CPU中的核显(如Intel Iris Xe Graphics)提供图形显示能力。然而,近年来Intel加大了在独立显卡领域的投入,推出了Arc系列独立显卡,旨在进入游戏和内容创作市场。Intel凭借其在CPU和制造工艺方面的深厚积累,有望在未来成为GPU市场的重要力量。

其他(华为、苹果等): 随着移动设备和边缘计算的兴起,越来越多的公司开始设计自己的GPU芯片。例如,苹果公司为其iPhone和Mac产品线设计了高性能的A系列和M系列芯片,其中集成了强大的GPU。华为海思也开发了用于移动设备的Mali系列GPU。虽然这些芯片主要用于特定生态系统,但它们也代表了GPU技术发展的一个重要方向。

七、 集成显卡与独立显卡芯片

显卡芯片的存在形式主要分为集成显卡和独立显卡。

集成显卡(Integrated Graphics Processing Unit,iGPU): 集成显卡是将GPU核心直接集成在CPU内部或主板芯片组中。这种方案的优点是成本较低、功耗较低、体积小,适用于办公、网页浏览、高清视频播放等日常应用。由于与CPU共享内存和总线带宽,其性能通常不如独立显卡,不适合运行大型三维游戏或进行专业图形处理。然而,随着技术的进步,一些高端集成显卡(如AMD的Radeon Graphics on APU和Intel的Iris Xe Graphics)的性能已经能够满足一些轻度游戏和内容创作需求。

独立显卡(Discrete Graphics Processing Unit,dGPU): 独立显卡是将GPU芯片、显存、供电模块等独立封装在一块PCB板上,通过PCIe接口插入主板。独立显卡拥有独立的显存和供电,以及更强大的GPU核心,能够提供远超集成显卡的图形处理能力,适用于大型三维游戏、专业图形设计、视频编辑、科学计算和人工智能等对图形性能要求较高的应用。独立显卡通常具有更好的散热系统和更丰富的显示输出接口。

八、 显卡芯片的性能指标

衡量显卡芯片性能的指标有很多,主要包括:

流处理器/CUDA核心数量: 核心数量越多,并行处理能力越强。

核心频率(Core Clock): GPU核心运行的频率,频率越高,单位时间内执行的指令越多。

显存容量(VRAM Size): 显存容量决定了显卡能存储多少图形数据,对于高分辨率、高纹理质量的游戏和应用非常重要。

显存位宽(Memory Bus Width): 显存位宽决定了GPU与显存之间数据传输的通道宽度,位宽越大,数据传输能力越强。

显存频率(Memory Clock): 显存运行的频率,与显存位宽共同决定显存带宽。

显存带宽(Memory Bandwidth): 显存带宽是衡量显存传输数据速度的关键指标,计算公式为:显存位宽 × 显存频率 / 8。带宽越大,GPU获取数据的速度越快。

填充率(Fill Rate): 衡量显卡每秒能够绘制多少像素或纹理的性能指标。

浮点运算能力(Floating-Point Operations Per Second,FLOPS): 衡量GPU每秒执行浮点运算的次数,通常用TeraFLOPS(TFLOPS)表示,反映了GPU的理论计算能力,尤其在通用计算和AI领域是重要指标。

PCIe版本和通道数: 更高版本的PCIe(如PCIe 4.0、PCIe 5.0)和更多的通道数(如x16)能够提供更高的带宽,减少CPU和GPU之间的数据传输瓶颈。

TDP(Thermal Design Power): 热设计功耗,表示显卡在典型负载下产生的热量,也间接反映了显卡的功耗水平。

九、 显卡芯片的未来趋势

显卡芯片的技术仍在快速发展,未来的发展趋势可能包括:

更小的制程与更高的集成度: 随着半导体制造工艺的不断进步,显卡芯片将集成更多的晶体管,从而提供更强大的性能和更高的能效比。3nm甚至更小制程的应用将使GPU的性能再上一个台阶。

更强的并行计算能力: GPU将继续增强其并行计算能力,在流处理器数量、核心频率和通用计算优化方面不断突破,以满足人工智能、科学计算等领域日益增长的需求。

光线追踪与路径追踪的普及: 随着硬件加速技术的成熟和游戏引擎的优化,实时光线追踪和更高级的路径追踪技术将越来越普及,为玩家带来更加真实的光影效果。

人工智能与机器学习的深度融合: GPU在AI领域的应用将更加广泛,未来可能出现更多专门为AI工作负载设计的GPU架构和指令集,实现更高效的AI训练和推理。

显存技术创新: HBM等高带宽显存技术将继续发展,提供更高的带宽和更低的功耗,以满足未来GPU对数据传输的巨大需求。同时,可能出现新的显存技术和架构。

异构计算与系统级芯片(SoC): 随着CPU、GPU、AI加速器等不同处理单元的融合,未来可能会出现更多高度集成的异构SoC,在一个芯片上实现更强大的综合计算能力,特别是在移动设备和边缘计算领域。

能效比的提升: 随着性能的提升,功耗和散热也面临挑战。未来的显卡芯片将更加注重能效比,通过架构优化、电源管理和更先进的制造工艺,在提供高性能的同时降低功耗。

软件生态与API发展: 显卡芯片的发展离不开软件生态的支持。未来的图形API(如DirectX、Vulkan)和通用计算框架(如CUDA、OpenCL)将不断演进,以充分发挥新硬件的潜力,并为开发者提供更强大的工具。

十、 总结

显卡芯片作为计算机图形和高性能计算的核心,其重要性不言而喻。从最初简单的显示输出到如今复杂的三维渲染、通用计算和人工智能加速,显卡芯片经历了数十年的飞速发展,每一次技术的突破都极大地推动了计算机应用和用户体验的进步。NVIDIA、AMD和Intel等厂商在激烈的竞争中不断创新,推出了性能更强、功能更丰富的GPU产品。

显卡芯片不仅仅是游戏玩家追求极致画质的利器,更是科学家进行复杂模拟、工程师进行产品设计、艺术家进行内容创作、数据分析师处理海量数据以及AI研究者训练深度学习模型的强大工具。它的并行计算能力使其在处理大规模并行任务时具有天然优势。

展望未来,随着人工智能、虚拟现实、增强现实和元宇宙等新兴技术的蓬勃发展,对图形处理和并行计算的需求将只增不长。显卡芯片将继续作为核心驱动力,在更小的制程下集成更多功能,提供更高的能效比和更强大的计算能力,从而在更广阔的领域发挥关键作用,塑造我们未来的数字世界。理解显卡芯片的基础知识,不仅能帮助我们更好地选择和使用计算机硬件,也能让我们洞察未来计算技术的发展方向。

责任编辑:David

【免责声明】

1、本文内容、数据、图表等来源于网络引用或其他公开资料,版权归属原作者、原发表出处。若版权所有方对本文的引用持有异议,请联系拍明芯城(marketing@iczoom.com),本方将及时处理。

2、本文的引用仅供读者交流学习使用,不涉及商业目的。

3、本文内容仅代表作者观点,拍明芯城不对内容的准确性、可靠性或完整性提供明示或暗示的保证。读者阅读本文后做出的决定或行为,是基于自主意愿和独立判断做出的,请读者明确相关结果。

4、如需转载本方拥有版权的文章,请联系拍明芯城(marketing@iczoom.com)注明“转载原因”。未经允许私自转载拍明芯城将保留追究其法律责任的权利。

拍明芯城拥有对此声明的最终解释权。

产品分类

产品分类

2012- 2022 拍明芯城ICZOOM.com 版权所有 客服热线:400-693-8369 (9:00-18:00)

2012- 2022 拍明芯城ICZOOM.com 版权所有 客服热线:400-693-8369 (9:00-18:00)