Nvidia在最新的MLPerf基准测试中展示Hopper

33

33

拍明芯城

拍明芯城

原标题:Nvidia在最新的MLPerf基准测试中展示Hopper

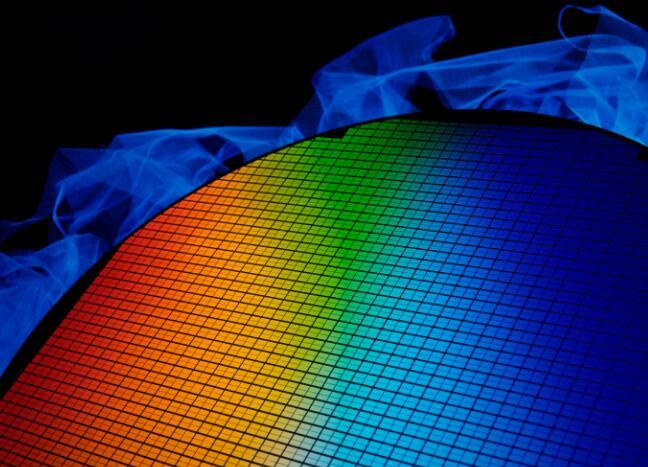

在最新的MLPerf基准测试中,NVIDIA再次展示了其强大的Hopper架构的实力。以下是关于NVIDIA Hopper在MLPerf基准测试中表现的详细概述:

测试结果概述:

NVIDIA的Grace Hopper超级芯片,特别是GH200型号,在MLPerf推理基准测试中取得了显著的成绩。这款超级芯片将一颗Hopper GPU和一颗Grace CPU连接到一个单一芯片中,提供了更大的内存、更快的带宽,并能够在CPU和GPU之间自动切换计算资源以实现性能最优化。

具体表现:

在MLPerf的测试中,内置8颗H100 GPU的NVIDIA HGX H100系统,在每一项MLPerf推理测试中均实现了最高吞吐量。

NVIDIA的Grace Hopper超级芯片和H100 GPU在所有MLPerf数据中心测试中均处于领先地位,这涵盖了针对计算机视觉、语音识别、医学成像的推理,以及应用于生成式AI的推荐系统和大语言模型(LLM)等对性能要求更高的用例。

技术亮点:

Hopper架构通过Transformer引擎推进Tensor Core技术的发展,旨在加速AI模型训练。Hopper Tensor Core能够应用混合的FP8和FP16精度,以大幅加速Transformer模型的AI计算。

Hopper架构与第四代NVIDIA NVLink和NVSwitch技术相结合,使得百亿亿次级高性能计算和万亿参数的AI模型能够在服务器集群中的每一个GPU之间实现平滑流畅的高速通信。

性能提升:

与上一代相比,Hopper架构在生成式AI训练和推理方面实现了惊人的速度提升。特别是针对GPT-J 6B模型,NVIDIA的TensorRT-LLM软件在H100 GPU上能够实现高达8倍的性能提升。

生态系统支持:

NVIDIA AI平台得到了业界最广泛的机器学习生态系统的支持。在MLPerf测试中,有超过70项提交结果是在NVIDIA平台上运行的,包括Microsoft Azure等云服务提供商以及华硕、戴尔科技、富士通等系统制造商。

综上所述,NVIDIA的Hopper架构在最新的MLPerf基准测试中再次展现了其强大的性能和领先地位,进一步巩固了NVIDIA在AI计算领域的领导地位。

责任编辑:David

【免责声明】

1、本文内容、数据、图表等来源于网络引用或其他公开资料,版权归属原作者、原发表出处。若版权所有方对本文的引用持有异议,请联系拍明芯城(marketing@iczoom.com),本方将及时处理。

2、本文的引用仅供读者交流学习使用,不涉及商业目的。

3、本文内容仅代表作者观点,拍明芯城不对内容的准确性、可靠性或完整性提供明示或暗示的保证。读者阅读本文后做出的决定或行为,是基于自主意愿和独立判断做出的,请读者明确相关结果。

4、如需转载本方拥有版权的文章,请联系拍明芯城(marketing@iczoom.com)注明“转载原因”。未经允许私自转载拍明芯城将保留追究其法律责任的权利。

拍明芯城拥有对此声明的最终解释权。

产品分类

产品分类

2012- 2022 拍明芯城ICZOOM.com 版权所有 客服热线:400-693-8369 (9:00-18:00)

2012- 2022 拍明芯城ICZOOM.com 版权所有 客服热线:400-693-8369 (9:00-18:00)