为人工智能应用铺平道路的技术

18

18

拍明芯城

拍明芯城

原标题:为人工智能应用铺平道路的技术

为人工智能应用铺平道路的技术是多方面的,以下是几种关键技术的详细归纳:

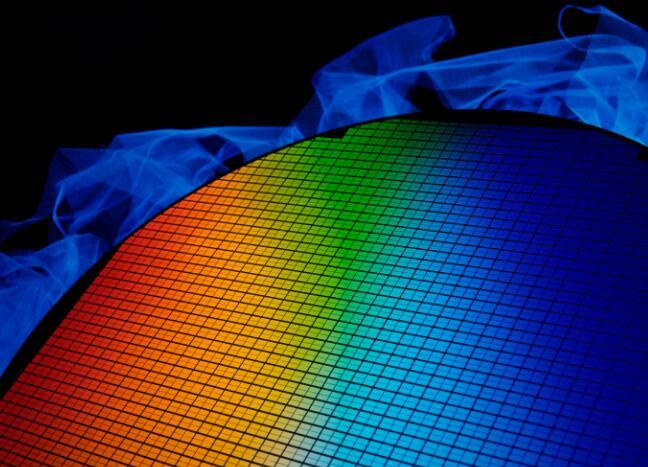

机器学习/大数据分析:

机器学习是人工智能应用中的核心技术之一,它使得计算机系统能够从数据中学习并改进其性能,而无需进行明确的编程。

大数据分析为机器学习提供了丰富的数据资源,通过挖掘和分析这些数据,机器学习算法能够发现模式、预测趋势,并据此做出决策。

例如,在建筑行业中,通过机器学习驱动的生成设计来识别和协作建筑、工程、机械、电气和管道计划,从而确保子团队之间没有冲突,降低了返工的风险。

自然语言生成技术:

自然语言生成技术允许计算机系统将数据转化为人类可以理解的语言,这在人工智能应用中尤为重要,因为它使得机器能够与人类进行交互和沟通。

例如,智能客服系统可以使用自然语言生成技术来理解和回应人类的问题和请求。

智能工作流技术:

智能工作流技术通过自动化和优化业务流程,提高了工作效率和准确性。

它允许人工智能系统根据预设的规则和条件来执行任务,减少了人为错误和延误。

在许多行业中,智能工作流技术被用于自动化重复性任务、优化资源分配和提高生产效率。

机器人流程自动化(RPA):

RPA通过模拟人类在计算机界面上的操作,按规则自动执行相应的流程任务,代替或辅助人类完成相关的计算机操作。

它被广泛应用于办公操作自动化,如数据录入、报表生成和邮件处理等。

RPA技术结合了大数据、人工智能和云计算等技术,能够辅助执行以往只有人类才能完成的工作,或作为人类高强度工作的劳动力补充。

计算机视觉与图像识别技术:

视觉人体关键点识别技术是其中的一种,它允许计算机系统通过视觉识别人体关键部位的位置来推断人体姿态。

这种技术在人机交互、智能安防、医学影像等领域具有广泛的应用前景。

例如,在体育领域,该技术可以用于对运动员进行技术分析和评估,帮助他们改进训练方案并提高运动表现。

物联网(IoT):

物联网通过将物理世界的设备连接到互联网,使得它们能够收集、交换和分析数据。

在人工智能应用中,物联网为机器学习提供了大量的实时数据,使得系统能够做出更准确的决策。

例如,在建筑行业中,建筑企业可以使用配备摄像头的人工智能机器人来捕捉3D图片,从而跟踪工作进度和识别质量错误。

综上所述,为人工智能应用铺平道路的技术涵盖了机器学习、大数据分析、自然语言生成、智能工作流、机器人流程自动化、计算机视觉与图像识别以及物联网等多个方面。这些技术的不断发展和融合,将进一步推动人工智能应用的广泛普及和深入发展。

责任编辑:David

【免责声明】

1、本文内容、数据、图表等来源于网络引用或其他公开资料,版权归属原作者、原发表出处。若版权所有方对本文的引用持有异议,请联系拍明芯城(marketing@iczoom.com),本方将及时处理。

2、本文的引用仅供读者交流学习使用,不涉及商业目的。

3、本文内容仅代表作者观点,拍明芯城不对内容的准确性、可靠性或完整性提供明示或暗示的保证。读者阅读本文后做出的决定或行为,是基于自主意愿和独立判断做出的,请读者明确相关结果。

4、如需转载本方拥有版权的文章,请联系拍明芯城(marketing@iczoom.com)注明“转载原因”。未经允许私自转载拍明芯城将保留追究其法律责任的权利。

拍明芯城拥有对此声明的最终解释权。

产品分类

产品分类

2012- 2022 拍明芯城ICZOOM.com 版权所有 客服热线:400-693-8369 (9:00-18:00)

2012- 2022 拍明芯城ICZOOM.com 版权所有 客服热线:400-693-8369 (9:00-18:00)