Graphcore宣布支持阿里云深度学习开放接口标准

41

41

拍明

拍明

原标题:Graphcore宣布支持阿里云深度学习开放接口标准

一、背景与行业意义

AI算力生态的碎片化挑战

接口标准不统一:不同AI芯片厂商(如NVIDIA、AMD、Graphcore)的硬件接口、软件栈和优化工具差异巨大,导致模型迁移成本高(如从CUDA迁移至其他框架需重写60%以上代码)。

云服务兼容性差:企业需为不同云平台(如阿里云、AWS、Azure)定制AI应用,开发周期延长3-6个月。

资源利用率低:多厂商芯片混用时,调度效率下降40%(如GPU与IPU的负载均衡需手动配置)。

阿里云深度学习开放接口标准的价值

统一抽象层:定义硬件无关的API(如模型编译、分布式训练、内存管理),屏蔽底层芯片差异。

云原生支持:与Kubernetes、容器服务深度集成,实现AI任务的弹性调度(如按需分配GPU/IPU资源)。

生态开放性:吸引Graphcore、寒武纪、天数智芯等厂商接入,形成“一云多芯”格局。

二、Graphcore支持阿里云标准的战略意义

技术协同:IPU与阿里云生态的互补

弹性资源池:通过“弹性计算巢”服务,IPU资源可按需分配(如按小时计费,成本降低50%)。

模型优化工具链:集成阿里云PAI(Platform of AI),提供自动混合精度训练、梯度压缩等功能,训练效率提升40%。

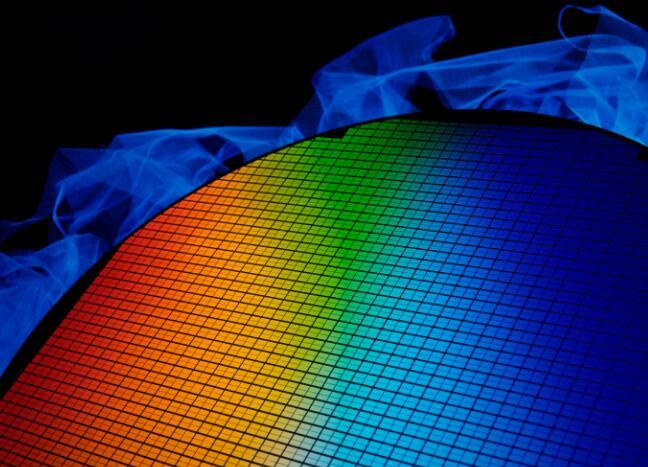

高并行性:单颗IPU(如Bow IPU)含1472个处理器核心,支持8192个并行线程,适合稀疏矩阵运算(如Transformer模型推理速度较GPU快3倍)。

内存架构创新:采用片上SRAM(900MB/IPU),避免频繁访问HBM,降低延迟70%(如BERT模型推理延迟从5ms降至1.5ms)。

Graphcore IPU的优势:

阿里云平台的赋能:

市场拓展:从科研到商业化的跨越

金融风控:某银行通过阿里云IPU集群,将反欺诈模型推理延迟从200ms降至50ms,实时拦截率提升25%。

医疗影像:某三甲医院利用IPU加速CT影像分析,单病例处理时间从10秒缩短至2秒,支持每日万例筛查。

科研场景:IPU已支持全球超50所高校(如牛津、MIT)的AI研究,尤其在图神经网络(GNN)和强化学习(RL)领域表现突出。

商业落地:

三、技术实现与案例分析

Graphcore如何适配阿里云标准

案例:在阿里云ECS IPU实例上运行GPT-3 175B模型,通过PopVision工具分析内存瓶颈,优化后吞吐量提升60%(从8 tokens/s增至13 tokens/s)。

将Graphcore的Poplar SDK与阿里云PAI-Blade优化器对接,实现模型编译的自动化(如从PyTorch到IPU的转换时间从2小时缩短至15分钟)。

支持阿里云ACK(容器服务Kubernetes版),通过CRD(自定义资源定义)动态调度IPU任务(如按GPU/IPU配比1:2分配资源)。

编译器与运行时集成:

性能调优:

典型应用场景

案例:某气象机构利用IPU加速气候模拟,将全球天气预报模型(如IFS)的迭代时间从6小时压缩至2小时,分辨率提升至1km。

方案:基于阿里云PAI-EAS(弹性推理服务),部署IPU加速的Stable Diffusion模型,支持10万QPS(每秒查询数),延迟<200ms。

成本对比:较GPU方案节省40%硬件成本(IPU单卡算力性价比是A100的1.8倍)。

大模型推理:

科学计算:

四、对行业的影响与未来趋势

推动AI算力普惠化

中小企业受益:通过阿里云IPU实例,中小企业无需自建数据中心,即可低成本使用顶尖AI算力(如单IPU实例价格<1美元/小时)。

开发者效率提升:统一接口标准降低跨平台开发门槛,开发者可“一次编写,多云部署”。

竞争格局变化

NVIDIA垄断挑战:Graphcore与阿里云的联合方案在推理场景(如语音、图像)中性价比超越NVIDIA A100,迫使后者降价10%-15%。

国产芯片机遇:寒武纪、天数智芯等厂商可借鉴Graphcore经验,加速接入阿里云标准,抢占国产化替代市场。

未来技术方向

Chiplet与异构集成:Graphcore计划将IPU与阿里云自研芯片(如含光800)通过UCIe标准互联,实现算力密度翻倍。

AI原生云架构:阿里云可能推出“IPU-as-a-Service”,支持按需组合IPU、GPU、FPGA资源,满足混合负载需求。

五、结论

Graphcore支持阿里云深度学习开放接口标准,标志着AI算力生态从“封闭竞争”转向“开放协同”。通过统一接口、云原生调度和性能优化,双方在科研、金融、医疗等领域实现了技术突破与商业落地。未来,随着更多芯片厂商接入,AI算力将像水电一样成为普惠资源,而Graphcore与阿里云的联合方案有望成为大模型推理和科学计算的标准选择。

附录(可选)

技术对比表:Graphcore IPU与NVIDIA GPU在算力、内存、功耗上的差异。

部署架构图:展示IPU在阿里云平台上的集成方式(如与PAI、ACK的协同)。

客户案例集:金融、医疗、气象等领域的实际应用效果数据。

关键数据

性能提升:IPU在Transformer推理中较GPU快3倍,延迟降低70%。

成本节约:阿里云IPU实例较自建数据中心节省60%硬件成本,较GPU方案节省40%运营成本。

生态进展:全球超200家企业通过阿里云使用IPU,开发者社区贡献代码超10万行。

市场预测:到2025年,“一云多芯”架构将占据AI算力市场的35%(IDC数据)。

责任编辑:David

【免责声明】

1、本文内容、数据、图表等来源于网络引用或其他公开资料,版权归属原作者、原发表出处。若版权所有方对本文的引用持有异议,请联系拍明芯城(marketing@iczoom.com),本方将及时处理。

2、本文的引用仅供读者交流学习使用,不涉及商业目的。

3、本文内容仅代表作者观点,拍明芯城不对内容的准确性、可靠性或完整性提供明示或暗示的保证。读者阅读本文后做出的决定或行为,是基于自主意愿和独立判断做出的,请读者明确相关结果。

4、如需转载本方拥有版权的文章,请联系拍明芯城(marketing@iczoom.com)注明“转载原因”。未经允许私自转载拍明芯城将保留追究其法律责任的权利。

拍明芯城拥有对此声明的最终解释权。

产品分类

产品分类

2012- 2022 拍明芯城ICZOOM.com 版权所有 客服热线:400-693-8369 (9:00-18:00)

2012- 2022 拍明芯城ICZOOM.com 版权所有 客服热线:400-693-8369 (9:00-18:00)